Численное решение систем линейных алгебраических уравнений

2.6.2. Методы градиентного и наискорейшего спуска

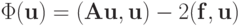

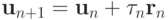

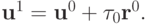

Метод градиентного спуска состоит в нахождении следующего приближения в итерационном процессе из предыдущего, путем смещения в направлении градиента функционала

|

( 2.25) |

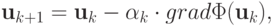

|

( 2.26) |

где  — положительно определенная симметричная

матрица;

— положительно определенная симметричная

матрица;  — параметр, определяемый из заданных условий; например, из условия минимума величины

— параметр, определяемый из заданных условий; например, из условия минимума величины

![\Phi \left[{{\mathbf{u}}_k - \alpha_k \cdot grad \Phi ({\mathbf{u}}_k)}\right].](/sites/default/files/tex_cache/311a0e89009aadae5aeb41649df828df.png)

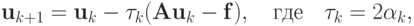

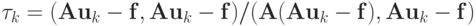

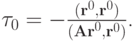

В этом случае итерационный метод называется методом наискорейшего спуска. Так как  , то (2.26) приобретает вид

, то (2.26) приобретает вид

|

( 2.27) |

что соответствует записи итерационного метода в форме {2.17). Здесь  является итерационным параметром, который в методе наискорейшего спуска определяется из условия минимума функции

является итерационным параметром, который в методе наискорейшего спуска определяется из условия минимума функции  по

по  Найдем условие этого минимума:

Найдем условие этого минимума:

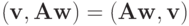

Здесь учтено соотношение:  , поскольку

, поскольку  и

и  в силу

самосопряженности оператора

в силу

самосопряженности оператора  Подставим в последние

равенства

Подставим в последние

равенства  из (2.27), получим

из (2.27), получим  , откуда следует

, откуда следует

, или

, или

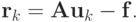

Вектор  называют вектором невязки.

называют вектором невязки.

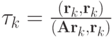

2.6.3. Метод минимальных невязок

Этот итерационный метод определяется следующим образом. Пусть  , как и

ранее,

, как и

ранее,  Итерационный параметр

Итерационный параметр  на каждой итерации выбирается так, чтобы минимизировать евклидову норму невязки

на каждой итерации выбирается так, чтобы минимизировать евклидову норму невязки  Заметим, что итерационный процесс

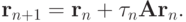

Заметим, что итерационный процесс  может быть представлен в равносильном виде в терминах невязки

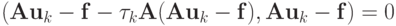

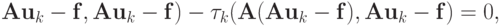

может быть представлен в равносильном виде в терминах невязки  Тогда для квадрата евклидовой (третьей) нормы невязки получаем условие

Тогда для квадрата евклидовой (третьей) нормы невязки получаем условие

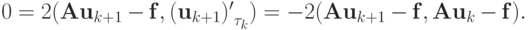

Для отыскания минимума невязки на следующей итерации приравняем нулю производную последнего выражения по итерационному параметру  Получим равенство

Получим равенство

Из последнего соотношения находим значение итерационного параметра

2.6.4. Метод сопряженных градиентов

Этот метод применяется для решения систем уравнений с самосопряженной

положительной матрицей  Оптимизируем градиентный метод, выбирая параметры

Оптимизируем градиентный метод, выбирая параметры  таким образом, чтобы на последующем шаге невязка была ортогональна всем предыдущим. На первом шаге невязку ищем аналогично методу наискорейшего спуска. Получим невязки, образующие ортогональный базис. На последнем шаге невязка становится равна нулю, так как пространство конечномерно, и единственный элемент, ортогональный всем базисным

векторам конечномерного пространства — нулевой. Получаем точное решение за конечное число шагов ( прямой метод ). Однако этот метод работает не всегда, так как при плохой обусловленности матрицы он становится вычислительно неустойчивым.

таким образом, чтобы на последующем шаге невязка была ортогональна всем предыдущим. На первом шаге невязку ищем аналогично методу наискорейшего спуска. Получим невязки, образующие ортогональный базис. На последнем шаге невязка становится равна нулю, так как пространство конечномерно, и единственный элемент, ортогональный всем базисным

векторам конечномерного пространства — нулевой. Получаем точное решение за конечное число шагов ( прямой метод ). Однако этот метод работает не всегда, так как при плохой обусловленности матрицы он становится вычислительно неустойчивым.

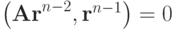

Идея метода состоит в следующем. Выбираем произвольное начальное приближение и вычисляем по нему вектор невязки  , тогда первое приближение

, тогда первое приближение

Из условия ортогональности невязок на двух первых шагах находим значение итерационного параметра

Построим такое приближение, чтобы учитывались две предыдущие — трехслойный итерационный метод. Фактически, при построении его применяется процесс ортогонализации Грамма-Шмидта. Если  , то

, то  —

—  - сопряженные невязки.

- сопряженные невязки.

Имеем метод сопряженных градиентов.

Все невязки уменьшаются по норме, поэтому данный метод эффективен даже для плохо обусловленных задач, т.к. на определенном шаге можно оборвать вычисления и получить приближение к решению с заданной точностью. Тогда этот метод становится итерационным.

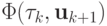

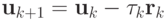

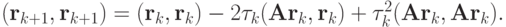

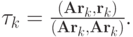

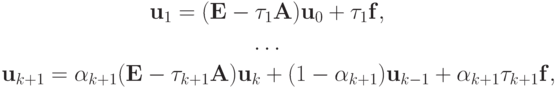

Приведем последовательность расчетных формул одного из вариантов метода сопряженных градиентов.

|

( 2.28) |

где

![$ \alpha_1 = 1; \alpha_{k+ 1}= {\left[{1 - \frac{1}{\alpha_k} \cdot \frac{\tau_{k+ 1}}{\tau_k} \cdot \frac{({\mathbf{r}}_k,{\mathbf{r}}_k)}{({\mathbf{r}}_{k- 1},{\mathbf{r}}_{k- 1})}}\right]}^{- 1},\quad k= 1, 2, \ldots $](/sites/default/files/tex_cache/9c7a19319cfe7ef968c351bd8d2be26d.png)

В вычислительной практике этот метод используется при умеренном числе обусловленности, больших n и неизвестных границах спектра матрицы  , как итерационный метод, поскольку k0 обычно достаточно большое число. Подробнее о методах сопряженных градиентов можно

прочитать в [2.2].

, как итерационный метод, поскольку k0 обычно достаточно большое число. Подробнее о методах сопряженных градиентов можно

прочитать в [2.2].