Методы генерации признаков

11.1. Генерация признаков на основе линейных преобразований

В данном разделе рассматриваются способы генерации признаков через линейные преобразования исходных измерений образов. Целью такой генерации признаков является сокращение информации до "значимой", т.е. надо просто преобразовать исходное множество измерений в новое множество признаков. Обычно задача состоит в выделении низкочастотных компонент, содержащих основную информацию.

11.1.1. Базисные вектора

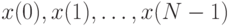

Пусть

-

– множество исходных измерений,

– множество исходных измерений, -

![X^T=[x(0),\ldots,x(N-1)]](/sites/default/files/tex_cache/7dbded4f48df32fa0791d555691a9a75.png) – соответствующий вектор столбец.

– соответствующий вектор столбец.

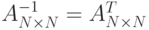

Рассмотрим унитарную матрицу  . Для

действительной матрицы

. Для

действительной матрицы  условие унитарности

обозначает, что матрица

условие унитарности

обозначает, что матрица  ортогональная, т.е.

ортогональная, т.е.  . Для комплексной

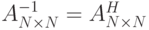

матрицы

. Для комплексной

матрицы  условие унитарности обозначает, что

условие унитарности обозначает, что  , где матрица

, где матрица  - транспонированная (сопряженная).

- транспонированная (сопряженная).

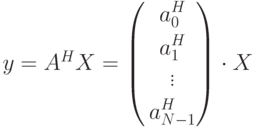

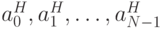

Пусть

– строки из транспонированных столбцов

– строки из транспонированных столбцов  и

и  .

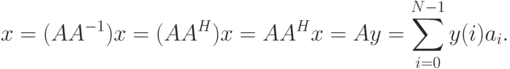

Тогда

.

Тогда

Вектора  называются базисными векторами.

Таким образом, в силу ортогональности

называются базисными векторами.

Таким образом, в силу ортогональности  между собой, y(i) – это проекция

вектора

между собой, y(i) – это проекция

вектора  на базисные вектора.

на базисные вектора.

11.1.2. Случай двумерных образов.

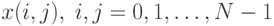

Пусть  – двумерные измерения.

Очевидно, что представление его в виде вектора размерности

– двумерные измерения.

Очевидно, что представление его в виде вектора размерности  неэффективно. Альтернативой является преобразование

неэффективно. Альтернативой является преобразование  через

базисные матрицы.

через

базисные матрицы.

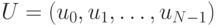

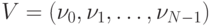

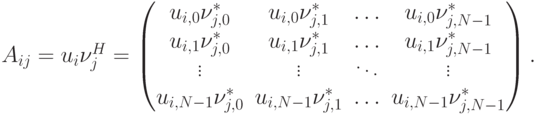

Пусть  и

и  – унитарные

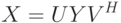

матрицы. Определим матрицу преобразования

– унитарные

матрицы. Определим матрицу преобразования  в

в  :

:

Учитывая, что  и

и  , имеем

, имеем

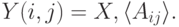

Следовательно

|

( 11.1) |

Пусть

-

, где

, где  – вектор-столбец,

– вектор-столбец, -

, где

, где  – вектор-строка.

– вектор-строка.

Тогда

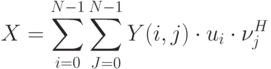

Таким образом (11.1) есть выражение  в терминах

в терминах  базисных матриц. Если

базисных матриц. Если  – диагональная, то (X=\sum_{i=0}^N-1) – это

разложение по базисным матрицам или образам.

– диагональная, то (X=\sum_{i=0}^N-1) – это

разложение по базисным матрицам или образам.

Также возможна следующая запись:

Тогда