Лекция 9: Логически прозрачные нейронные сети и производство явных знаний из данных

Процедура контрастирования

Процедура контрастирования основана на оценке значимости весов связей в сети. Впервые процедура контрастирования нейронных сетей на основе показателей чувствительности описана одновременно в [9.1] и (существенно более частный вариант) в [9.2]. В книге [9.1] указаны основные цели контрастирования: упростить техническую реализацию сети и сделать навык сети более понятным - явизовать (сделать явным) знание, полученное сетью в ходе обучения.

Результаты экспериментов по контрастированию нейронных сетей опубликованы в [9.7, 9.8]. Существуют также подходы, не использующие показатели чувствительности [9.3]. Уже в [9.1] описано несколько способов вычисления показателей чувствительности. Приведем два наиболее широко используемых.

Контрастирование на основе оценки

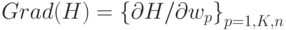

Рассмотрим сеть, правильно решающую все примеры обучающего множества. Обозначим через  веса всех связей. При обратном функционировании сети по принципу двойственности или методу обратного распространения ошибки сеть вычисляет вектор градиента функции оценки H по весам связей -

веса всех связей. При обратном функционировании сети по принципу двойственности или методу обратного распространения ошибки сеть вычисляет вектор градиента функции оценки H по весам связей -  . Пусть

. Пусть  - текущий набор весов связей, а оценка текущего примера равна

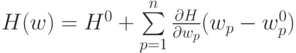

- текущий набор весов связей, а оценка текущего примера равна  . Тогда в линейном приближении можно записать функцию оценки в точке w как

. Тогда в линейном приближении можно записать функцию оценки в точке w как  . Используя это приближение можно

оценить изменение оценки при замене

. Используя это приближение можно

оценить изменение оценки при замене  на как

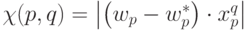

на как  , где q - номер примера обучающего множества, для которого были вычислены оценка и градиент. Величину

, где q - номер примера обучающего множества, для которого были вычислены оценка и градиент. Величину  будем называть показателем чувствительности к замене

будем называть показателем чувствительности к замене  на

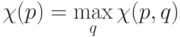

на  для примера q . Далее необходимо вычислить показатель чувствительности, не зависящий от номера примера. Для этого можно воспользоваться любой нормой. Обычно используется равномерная норма (максимум модуля):

для примера q . Далее необходимо вычислить показатель чувствительности, не зависящий от номера примера. Для этого можно воспользоваться любой нормой. Обычно используется равномерная норма (максимум модуля):  . Умея вычислять показатели чувствительности, можно приступать к процедуре контрастирования.

. Умея вычислять показатели чувствительности, можно приступать к процедуре контрастирования.

Приведем простейший вариант этой процедуры:

- Вычисляем показатели чувствительности.

- Находим минимальный среди показателей чувствительности -

.

. - Заменим соответствующий этому показателю чувствительности вес

на

на  , и исключаем его из процедуры обучения.

, и исключаем его из процедуры обучения. - Предъявим сети все примеры обучающего множества. Если сеть не допустила ни одной ошибки, то переходим ко второму шагу процедуры.

- Пытаемся обучить отконтрастированную сеть. Если сеть обучилась безошибочному решению задачи, то переходим к первому шагу процедуры, в противном случае переходим к шестому шагу.

- Восстанавливаем сеть в состояние до последнего выполнения третьего шага. Если в ходе выполнения шагов со второго по пятый был отконтрастирован хотя бы один вес, (число обучаемых весов изменилось), то переходим к первому шагу. Если ни один вес не был отконтрастирован, то получена минимальная сеть.

Возможно использование различных обобщений этой процедуры. Например, контрастировать за один шаг процедуры не один вес, а заданное пользователем число весов. Наиболее радикальная процедура состоит в контрастировании половины весов связей. Если половину весов отконтрастировать не удается, то пытаемся отконтрастировать четверть и т.д. Отметим, что при описанном методе вычисления показателей чувствительности, предполагается возможным вычисление функции оценки и проведения процедуры обучения сети, а также предполагается известным обучающее множество. Возможен и другой путь.

Контрастирование без ухудшения

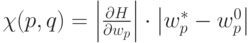

Пусть нам дана только обученная нейронная сеть и обучающее множество. Допустим, что вид функции оценки и процедура обучения нейронной сети неизвестны. В этом случае так же возможно контрастирование сети. Предположим, что данная сеть идеально решает задачу. Тогда нам необходимо так отконтрастировать веса связей, чтобы выходные сигналы сети при решении всех задач изменились не более чем на заданную величину. В этом случае контрастирование весов производится понейронно. На входе каждого нейрона стоит адаптивный сумматор, который суммирует входные сигналы нейрона, умноженные на соответствующие веса связей. Для нейрона наименее чувствительным будет тот вес, который при решении примера даст наименьший вклад в сумму. Обозначив через  входные сигналы рассматриваемого нейрона при решении q -го примера получаем формулу для показателя чувствительности весов:

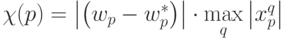

входные сигналы рассматриваемого нейрона при решении q -го примера получаем формулу для показателя чувствительности весов:  . Аналогично ранее рассмотренному получаем

. Аналогично ранее рассмотренному получаем  . В самой процедуре контрастирования есть только одно отличие - вместо проверки на наличие ошибок при предъявлении всех примеров проверяется, что новые выходные сигналы сети отличаются от первоначальных не более чем на заданную величину.

. В самой процедуре контрастирования есть только одно отличие - вместо проверки на наличие ошибок при предъявлении всех примеров проверяется, что новые выходные сигналы сети отличаются от первоначальных не более чем на заданную величину.