Базовые понятия теории информации

Вероятностный подход к измерению дискретной и непрерывной информации

В основе теории информации лежит предложенный Шенноном способ измерения количества информации, содержащейся в одной случайной величине, относительно другой случайной величины. Этот способ приводит к выражению количества информации числом.

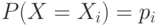

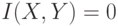

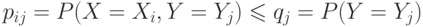

Для дискретных случайных величин  и

и  , заданных законами распределения

, заданных законами распределения  ,

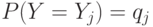

,  и совместным распределением

и совместным распределением  , количество информации, содержащейся в

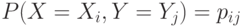

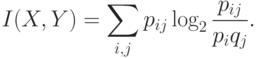

, количество информации, содержащейся в  относительно

относительно  , равно

, равно

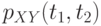

Для непрерывных случайных величин,  и

и  , заданных

плотностями распределения

вероятностей

, заданных

плотностями распределения

вероятностей  ,

,  и

и  , аналогичная формула

имеет вид

, аналогичная формула

имеет вид

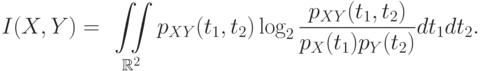

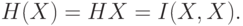

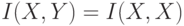

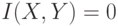

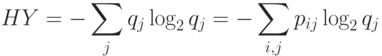

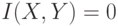

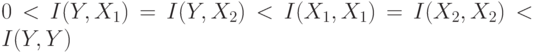

Очевидно, что

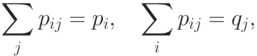

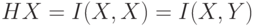

Энтропия дискретной случайной величины  в теории информации определяется

формулой

в теории информации определяется

формулой

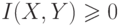

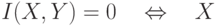

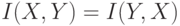

Свойства меры информации и энтропии:

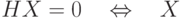

-

,

,  и

и  независимы;

независимы; -

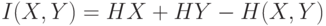

;

; -

- константа;

- константа; -

, где

, где  ;

; -

. Если

. Если  ,

то

,

то  - функция от

- функция от  .

Если

.

Если  - инъективная функция1Функция

- инъективная функция1Функция  - инъекция, если на разных

значениях аргумента, она принимает разные

значения. от

- инъекция, если на разных

значениях аргумента, она принимает разные

значения. от  , то

, то  .

.

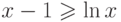

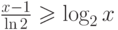

- Логарифмированием из очевидного для всех

неравенства

неравенства  (равенство устанавливается только при

(равенство устанавливается только при  ) получается

неравенство

) получается

неравенство  или

или  .

. т.е.

т.е.

только при

только при  для

всех

для

всех  и

и  , т.е. при независимости

, т.е. при независимости  и

и  .

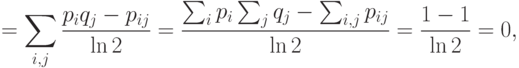

Если

.

Если  и

и  независимы, то

независимы, то  и, следовательно, аргументы

логарифмов равны 1 и, следовательно, сами логарифмы равны 0, что означает, что

и, следовательно, аргументы

логарифмов равны 1 и, следовательно, сами логарифмы равны 0, что означает, что  ;

; - Следует из симметричности формул относительно аргументов;

- Если

, то все члены суммы, определяющей

, то все члены суммы, определяющей  , должны быть нули, что

возможно тогда и только тогда, когда

, должны быть нули, что

возможно тогда и только тогда, когда  - константа;

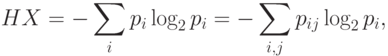

- константа; - Из четырех очевидных соотношений

получается

получается

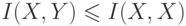

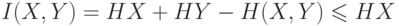

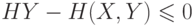

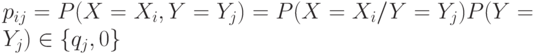

- Нужно доказать

или

или  .но

.но

, а значит аргументы у

всех логарифмов не больше 1 и, следовательно, значения логарифмов не больше 0, а

это и значит, что вся сумма не больше 0.

, а значит аргументы у

всех логарифмов не больше 1 и, следовательно, значения логарифмов не больше 0, а

это и значит, что вся сумма не больше 0.

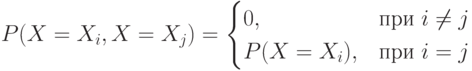

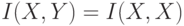

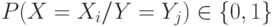

Если  , то для каждого

, то для каждого

равно либо

равно либо  ,

либо 0. Но из

,

либо 0. Но из  следует

следует  , что возможно только в случае,

когда

, что возможно только в случае,

когда  - функция от

- функция от  .

.

При независимости случайных величин,  и

и  одна из них

ничем не описывает другую, что и отражается в том, что для таких случайных величин,

одна из них

ничем не описывает другую, что и отражается в том, что для таких случайных величин,  .

.

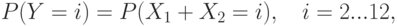

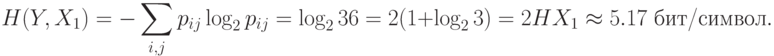

Рассмотрим пример измерения количества информации при подбрасывании двух игральных костей.

Пусть заданы дискретные случайные величины  ,

,  и

и  .

.  и

и  - количества

очков, выпавших соответственно на 1-й и 2-й игральной кости, а

- количества

очков, выпавших соответственно на 1-й и 2-й игральной кости, а  .

Найти

.

Найти  ,

,  ,

,  .

.

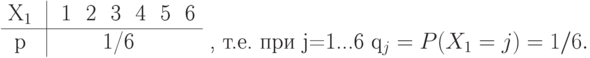

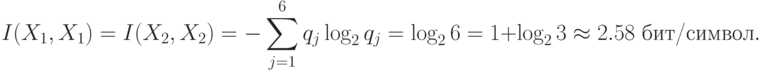

Законы распределения вероятностей для дискретной случайной величины  и

и  совпадают, т.к. кости одинаковые и без изъянов.

совпадают, т.к. кости одинаковые и без изъянов.

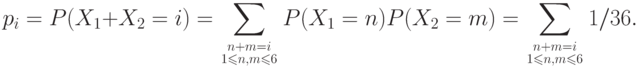

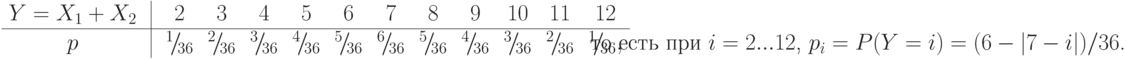

Закон распределения вероятностей для дискретной случайной величины  ,

,

,

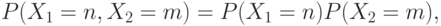

,  - независимы и

поэтому

- независимы и

поэтому

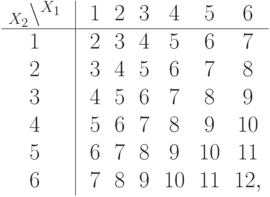

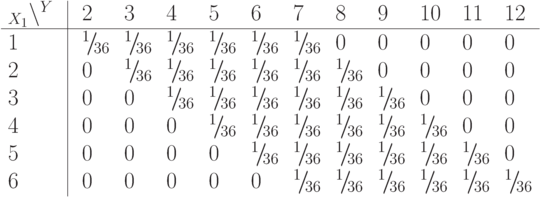

Таблицы, определяющие  :

:

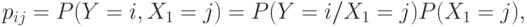

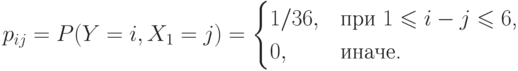

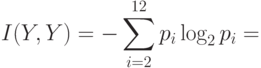

Закон совместного распределения вероятностей дискретной случайной величины  и

и  будет

будет

. В общем случае получится

. В общем случае получится

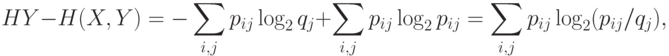

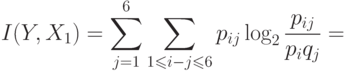

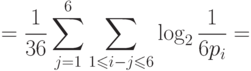

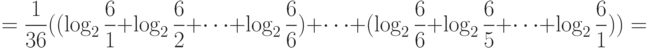

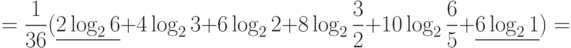

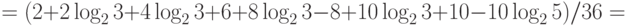

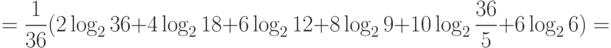

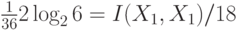

Тогда

Здесь  , что соответствует свойствам информации.

, что соответствует свойствам информации.

Подчеркнутый член  в расчете

в расчете  соответствует информации о двух случаях из 36, когда

соответствует информации о двух случаях из 36, когда  и

и  , которые однозначно определяют

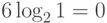

, которые однозначно определяют  . Шесть случаев, когда

. Шесть случаев, когда  , не несут никакой информации об

, не несут никакой информации об  , что соответствует подчеркнутому члену

, что соответствует подчеркнутому члену  .

.

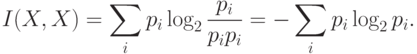

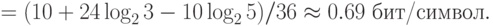

Расчеты можно проводить, используя 4-е свойство информации, через энтропию.

Расчет количества информации с использованием 4-го свойства, а не определения, обычно требует меньше вычислений.