Вопросы безопасности и этики применения ИИ

Отсутствие прозрачности ИИ - это проблема, которая уже упоминалась ранее и будет более подробно рассмотрена в данном разделе. Некоторые системы ИИ являются "черным ящиком" и не поддаются объяснению. Трудно оценить систему, когда нет возможности понять, как она делает свои выводы.

Предвзятость (bias) - термин, который можно интерпретировать как необъективность или пристрастность ИИ. Эта необъективность может формироваться на разных стадиях жизненного цикла создания модели. Во-первых, сами разработчики не могут быть свободны от присущей им той или иной пристрастности (принадлежности той или иной социальной группе, политическим предпочтениям и т. п.), они переносят часть своей личности в ИИ-продукты, порождая предвзятости решения. Вот почему считается, что страны, в которых разработчики представлены разными социальными и гендерными слоями, в меньшей степени рискуют создавать ИИ-приложения, страдающие предвзятостями.

Предвзятости также могут формироваться на стадии постановки задачи, когда формализация задачи может зависеть от личных представлений разработчика. А также на стадии сбора данных для обучения. Например, в 2019 году полицейское управление Лос-Анджелеса приостановило свою программу прогнозирования преступности LASER, которая использовала данные видеоаналитики, после того как внутренний аудит показал предвзятость системы к чернокожим и латиноамериканцам.

Системы ИИ могут усиливать риски, связанные с предвзятыми результатами, приводя к нарушению конфиденциальности, этических норм, что в свою очередь приводит к судебным и репутационным издержкам.

Риски, связанные с нарушением нормативных требований

По мере внедрения ИИ в организациях необходимо учитывать их влияние на существующие внутренние политики. Регулирующие органы проявляют растущий интерес к внедрению ИИ. Несоблюдение нормативных актов может повлиять на использование и управление системами ИИ.

В рамках данного курса мы подробнее остановимся на рисках, связанных с ограничениями интерпретируемости ИИ-систем, и рис

Ограниченная интерпретируемость ИИ как фактор риска

Как было отмечено, не все системы ИИ являются объяснимыми, часть из них работают как "черный ящик", делая вывод с определенной вероятностью и не имея возможности объяснить логику принятия решения. Понятно, что чем меньше доверие к ИИ, тем уже сферы его применения. Из-за отсутствия понимания механизма получения вывода люди, использующие системы "черного ящика", допускают ошибки в некоторых "безопасных" пределах и избегают использовать подобные решения в ответственных приложениях.

Чтобы создать ИИ-приложение, которое можно использовать на практике, необходимо обеспечить соответствие требованиям безопасности, нормам этики, люди должны понимать обстоятельства, которые привели к результатам, и исправлять их, если они ошибочны.

Наше общество уже сталкивается с ситуациями, когда проявляются ошибки, связанные с работой систем на базе ИИ. Когда, например, ошибка в распознавании лица приводит к задержанию невиновного человека, когда люди в критических ситуациях теряют доступ к денежным пособиям, когда алгоритмы неправильно интерпретируют медицинские снимки, неправильно ставят диагнозы. Проблема не в том, что ИИ-системы ошибаются, а в том, что если логика принятия решений остается неочевидна человеку, то такие ошибки остаются неподконтрольными и в этой связи часто неисправимыми.

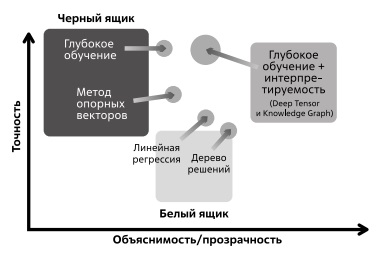

На рис. 4.3 показано несколько рассмотренных нами ранее алгоритмов, на базе которых строятся системы ИИ. Как видно из рисунка, глубокое обучение, которое может обеспечить высокую точность, уступает более простым алгоритмам по параметру объяснимости.

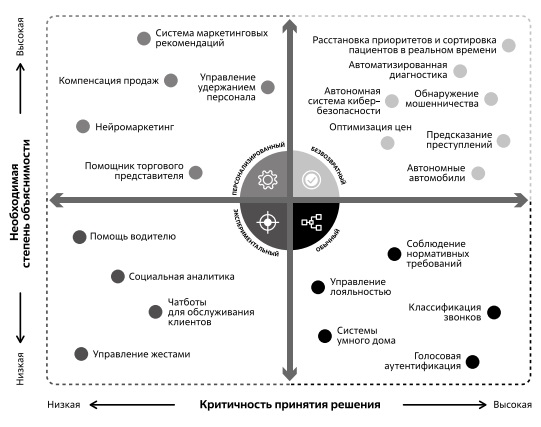

Объяснимость ИИ становится все более критичной по мере роста ответственности за принятие решения на базе ИИ (рис. 4.4).

Рис. 4.4. Степень критичности интерпретируемости ИИ зависит от уровня ответственности за принятие решения на базе ИИ

Сортировка пациентов для принятия экстренных медицинских процедур, постановка диагноза, определение нарушителей в мошеннических схемах - это те случаи, где важность принятия решения высока, где ошибка может привести к большим издержкам и где степень востребованности объяснимого ИИ, соответственно, велика. Задача состоит в построении решения, обладающего высокой точностью и интерпретируемостью (рис. 4.4). Как может быть реализовано подобное решение?

На рис. 4.5 показана принципиальная схема сравнения неинтерпретируемого (верхняя часть) и интерпретируемого решения (нижняя часть). В верхней части рис. 4.5 на вход в "черный ящик" подается фотография кошки, и на выходе мы получаем вывод - маркированное изображение. Модель, например, сообщает, что с вероятностью 95% это кошка, но при этом мы не знаем, как и почему система сделала такой вывод.

Объяснимые системы ИИ не просто выдают результат, а предполагают интерактивность с пользователем, предоставляя интерфейс, в рамках которого обеспечивается дополнительная информация, которая помогает человеку понять, как и почему ИИ принял такое решение, что позволяет проанализировать работу системы, если она работает неправильно.