Планирование

Планирование высокой доступности

Основная цель планирования кластера высокой доступности состоит в том, чтобы исключить и свести к минимуму простои в работе требуемого приложения. С этой целью необходимо устранить единые точки отказа как в аппаратном, так и в программном обеспечении. Обычно это достигается путем дублирования оборудования по схеме "N+1", в частности путем дублирования источников питания, сетевых интерфейсов, адаптеров SAN и конфигураций зеркального отображения или RAIDдисков. Все эти компоненты увеличивают стоимость сервера, но могут не защитить приложение в случае отказа сервера или операционной системы.

Здесь наступает очередь HACMP. В HACMP можно настроить мониторинг серверного оборудования, операционной системы и компонентов приложения. В случае отказа HACMP может предпринять корректирующие действия, в частности выполнить перемещение требуемых ресурсов (сервисных IP-адресов, хранилищ и приложений) на рабочие компоненты кластера, чтобы как можно быстрее восстановить доступность приложения.

HACMP является чрезвычайно гибким продуктом, поэтому разработка кластера под нужды организации требует тщательного планирования. Требования и режим функционирования приложения представляют важную входную информацию плана HACMP и являются основными факторами при определении схемы кластера. При разработке схемы кластера необходимо поставить перед собой следующие вопросы:

- Для каких служб приложений необходимо обеспечить высокую доступность?

- Каковы требования к уровню обслуживания для этих служб приложений (24x7, 8x5) и насколько быстро должно выполняться восстановление обслуживания в случае отказа?

- Каковы потенциальные точки отказа в среде и как их можно устранить?

- Какие точки отказа могут быть автоматически обнаружены HACMP и для каких потребуется написать специальный код для вызова события?

- Каким должен быть уровень квалификации в группе, осуществляющей внедрение и обслуживание кластера?

Хотя за внедрение HACMP обычно отвечают системные администраторы AIX, как правило, они не могут заниматься этим самостоятельно. Для помощи в планировании HACMP следует создать команду, состоящую из следующих представителей, каждый из которых играет важную роль в успешной работе кластера:

- сетевой администратор;

- системный администратор AIX;

- администратор баз данных;

- разработчик приложений;

- персонал поддержки;

- пользователи приложения.

Планирование HACMP

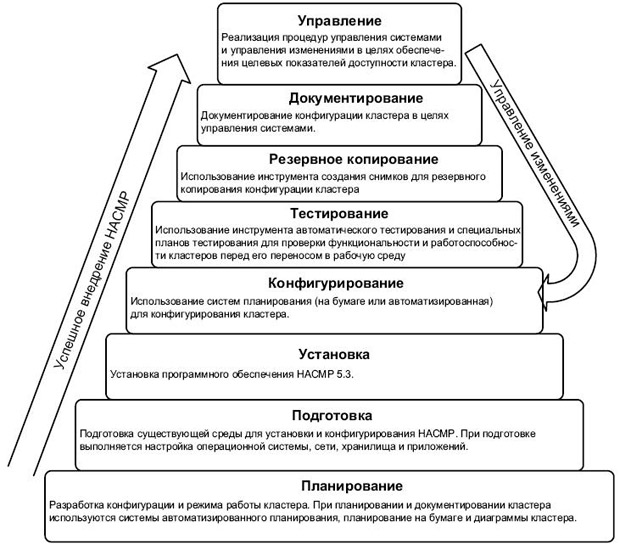

Основные этапы успешного внедрения HACMP указаны на рис. 3.1. Обратите внимание на то, что внедрение кластера не завершается с успешным конфигурированием кластера. Процедуры тестирования кластера, резервного копирования, документирования и текущего управления одинаково важны для обеспечения текущей целостности кластера.

Используя понятия, описанные в "Введение в HACMP" , "Введение в HACMP", внедрение HACMP начинается с разработки подробного плана конфигурирования и внедрения кластера HACMP. Для направления этого процесса и записи информации о кластере можно использовать такие инструменты планирования, как таблицы планирования на бумаге (Paper Planning Worksheets), описываемые в руководстве High Availability Cluster Multi-Processing for AIX 5L Planning and Installation Guide, SC23-4861-06, и система автоматизированного планирования (Online Planning Worksheets).

Как показано на рис. 3.1, планирование является основой, на которой строится внедрение. Надлежащее планирование должно затрагивать все аспекты внедрения кластера. Оно должно включать:

- схему и режим работы кластера;

- подробную конфигурацию кластера;

- аспекты и план установки;

- план тестирования целостности кластера;

- стратегию резервного копирования для кластера;

- процедуру документирования кластера;

- план управления проблемами и изменениями в кластере.

Для простоты описания мы представим планирование кластера на примере кластера из двух узлов со взаимным перехватом. Эта конфигурация является отправной точкой для более сложных установок. Лекция также содержит образцы таблиц планирования, так как цель лекции заключается в том, чтобы показать, как выполняется планирование кластера.

Инструменты планирования

При планировании кластера HACMP можно использовать три инструмента:

- диаграмму кластера;

- таблицы планирования на бумаге (Paper Planning Worksheets);

- система автоматизированного планирования (Online Planning Worksheets).

И диаграмма кластера и таблицы планирования на бумаге представляют собой метод записи информации о кластере вручную. Система автоматизированного планирования представляет простой в использовании интерфейс на основе Java, который может применяться для записи и конфигурирования кластера.

Приступая к работе

Планирование кластера начинается с анализа текущей среды и своих ожиданий от HACMP:

- Для каких приложений необходимо обеспечить высокую доступность?

- Сколько узлов необходимо для поддержки приложений?

- Существуют ли узлы достаточного размера (процессор/память) для выполнения нескольких приложений или устанавливаются новые узлы?

- Как клиенты подключаются к приложению, какова конфигурация сети?

- Какой тип общего диска будет использоваться?

- Каковы ожидания от HACMP?

Текущая среда

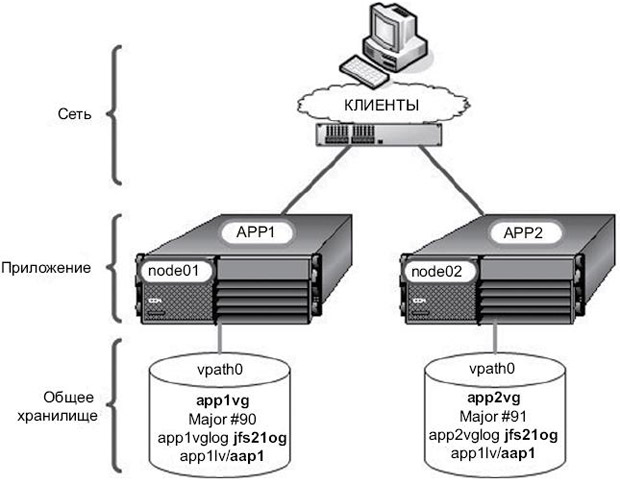

На рис. 3.2 показана простая стартовая конфигурация, которую мы будем использовать в качестве примера. Она сосредоточена на обеспечении высокой доступности двух приложений. Это может быть либо пара существующих серверов, либо два новых сервера.

Стартовая конфигурация показывает следующее:

- каждое приложение находится на отдельном узле (сервере);

- клиенты осуществляют доступ к каждому приложению через выделенное Ethernetподключение на каждом сервере;

- каждый узел имеет приблизительно один размер с точки зрения процессора и памяти, каждый имеет дополнительную мощность;

- каждый узел имеет дополнительные источники питания и внутренние диски с зеркальным отображением;

- приложения расположены на внешнем диске SAN;

- каждое приложение имеет собственные надежные скрипты запуска и остановки;

- существует инструмент мониторинга для проверки состояния каждого приложения;

- AIX 5.3 уже установлен.

Цель состоит в том, чтобы использовать два узла в конфигурации со взаимным перехватом, где приложение app1 обычно находится на узле node01, а приложение app2 обычно находится на узле node02. В случае отказа нужно, чтобы оба приложения выполнялись на оставшемся сервере. Из диаграммы мы видим, что нужно подготовить среду таким образом, чтобы каждый узел мог выполнять оба приложения.

Анализируя требования к кластеру HACMP, получаем три основные области, требующие внимания, как показано на рис. 3.2: сеть, приложение и хранилище. Все действия по планированию в какой-то мере предназначены для поддержки одного из трех этих элементов.

- Сеть – каким образом клиенты подключаются к приложению (сервисный адрес). Сервисный адрес может перемещаться между всеми выделенными узлами кластера.

- Приложение – какие ресурсы необходимы для приложения. Приложение должно располагать всем, что ему необходимо для работы на узле перемещения при сбое, включая ресурсы процессора и памяти, лицензии, исполняемые модули и данные конфигурации. Оно должно иметь надежные скрипты запуска и остановки, а также инструмент для мониторинга своего состояния.

- Хранилище – какой тип общего диска будет использоваться. Данные приложения должны располагаться на общем диске, доступном для всех требуемых узлов кластера.