|

"Тогда как задать возбуждение рецепторов, если инспектор точно установил, что скорость автомобиля при наезде на пешехода была равна 114 км/час? Вопрос по расчёту скорости и сумме достоверности: этот математический (приведенный выше в виде контекста из материала лекции 1, страницы 3) метод справедлив к скоростным показателям выходящим за рамки диапазона 100-120. |

Развитие логической нейронной сети для распознавания объектов по заданному набору признаков

Детерминированные оценки объектов временного ряда

А г а ф ь я Т и х о н о в н а. ...Если бы губы Никанора Ивановича да приставить к носу Ивана Кузьмича, да взять сколько-нибудь развязности, какая у Балтазара Балтазарыча, да, пожалуй, прибавить к этому еще дородности Ивана Павловича – я бы тогда тотчас же решилась.

Важным объектом анализа и исследования в области информационных технологий являются временные ряды. Временной ряд характеризуется реальным временем поступления данных, например, - от регистрирующей аппаратуры при проведении испытаний сложных систем, и столь же оперативной обработкой этих данных. Обработка возможна и с меньшим темпом – при частичном накоплении информации. Однако всегда можно выделить ту первичную обработку, которая проводится в темпе поступления информации, т.е. в реальном масштабе времени.

Первичная обработка временного ряда связана с распознаванием и классификацией данных для запуска средств последующей их обработки. Это порождает надежду на эффективное применение на данном этапе таких средств искусственного интеллекта, как логические нейронные сети.

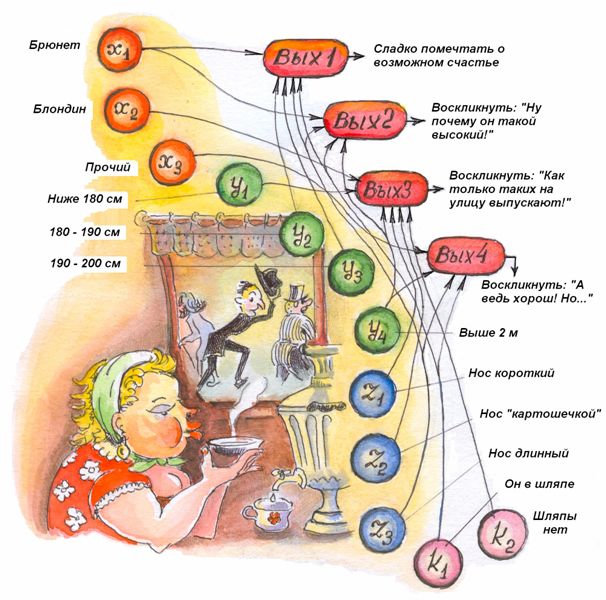

Маша хочет замуж... Нескончаемой чередой мимо ее окошка по городской улице проходят мужчины... Идеал настоящего мужчины, достойного стать ее мужем, Маша определила по следующим свойствам – признакам:

- Он брюнет;

- Его рост – не менее 180 см;

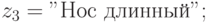

- Он обладатель длинного носа;

- Он должен носить шляпу.

Поток мужчин настолько интенсивен, что Маша принимает единственно правильное решение: она должна автоматизировать процесс селекции мужчин, обладающих указанными признаками, для того чтобы в реальном времени, с применением методов распараллеливания, проводить (в своих мечтах) обработку встретившегося "кандидата".

Итак, имеется временной ряд – поток объектов, характеризующийся набором данных по каждому из них. Необходимо так же в реальном времени решать задачи обработки этих объектов. Эти задачи разнообразны: аппроксимация функциями времени, вероятностная обработка результатов испытаний, обработка динамики состояния фондового рынка, динамический контроль состояния сложной системы и т.д.

Среди этих задач важное место занимает задача селекции и идентификации – задача ассоциативного поиска по эталону. Такая задача возникает, например, при сопровождении спутника, вновь появившегося в секторе обзора.

В простейшей постановке задача формулируется следующим образом.

Объекты, составляющие временной ряд, т.е. последовательно предъявляемые для обработки, обладают множеством признаков  . Задан эталон, соответствующий фиксированному значению этих признаков

. Задан эталон, соответствующий фиксированному значению этих признаков  . Необходимо в динамике последовательного анализа объектов временного ряда выделять (и направлять на специальную обработку) те объекты, где все значения признаков совпадают с эталонными,

. Необходимо в динамике последовательного анализа объектов временного ряда выделять (и направлять на специальную обработку) те объекты, где все значения признаков совпадают с эталонными,  .

.

Обобщением постановки этой задачи, превращающим ее в задачу классификации, является следующее дополнение: Произвести распознавание каждого возможного набора значений признаков  для принятия решения по дальнейшей обработке объекта, признаки которого обладают этими значениями. Очевидно, решение данной задачи включает в себя решение задачи, поставленной ранее.

для принятия решения по дальнейшей обработке объекта, признаки которого обладают этими значениями. Очевидно, решение данной задачи включает в себя решение задачи, поставленной ранее.

Основным элементом данной задачи является распознавание. В общем случае оно усложняется тем, что точное совпадение признаков с эталонными маловероятно. В этом случае можно говорить лишь о допустимой степени достоверности этого совпадения. Правомочен вопрос: "На какой эталон в значительной степени похож анализируемый объект?" Это указывает на эффективность применения параллельных нейросетевых технологий, опирающихся на несложный расчет значений передаточной функции нейроподобного элемента, лежащий в основе модели ассоциативного мышления и адекватно отображаемый логической нейронной сетью.

Конечно, Маша могла бы построить традиционный алгоритм последовательного анализа признаков проходящих мужчин. Затем бы она решила проблему минимизации сложности полученного алгоритма. Она бы догадалась, что минимизировать количество основных операций сравнения можно, если проводить это сравнение, упорядочив признаки по не убыванию частоты появления интересующего значения.

Например, она заметила, что реже всего появляются мужчины в шляпах. Тогда, если она увидит мужчину в шляпе, это повлечет анализ других признаков. Значит, чем реже будут встречаться мужчины в шляпах, тем реже придется отвлекаться на дополнительное сравнение. В то же время, сокращение затрат на последующий анализ мужчины в шляпе требует, чтобы интересующее значение признака, с которого этот анализ начинается, также был редко встречающимся и т.д.

Однако такой порядок анализа признаков требует периодического исследования выборок из временного ряда для выявления частоты появления требуемых значений признаков. В комплексе, исследование ряда и частотный анализ значений признаков (по каждому эталону!) можно рассматривать как путь построения самонастраивающегося (по минимуму требуемой производительности) алгоритма поиска с помощью последовательного сравнения значений признаков с эталонными.

Машу такой путь не устраивает. Ей хочется получить алгоритм параллельного анализа всех признаков сразу, методом, подобным методу ассоциативного мышления – для дальнейшего обоснования применения параллельных вычислительных средств: многопроцессорного суперкомпьютера, кластера локальной вычислительной сети или нейрокомпьютера. Кроме того, она рассчитывает в дальнейшем принимать решения не по единственному эталону и даже – не по единственному идеалу.

Приступим к формированию логической нейронной сети – основы машиной системы принятия решений (рис.5.1).

Для формирования нейронов рецепторного слоя произведем градацию "мужских" признаков па основе понятия исчерпывающего множества событий.

- Пусть в Машином представлении мужчины бывают брюнеты, блондины, прочие. Это требует введения трех нейронов-рецепторов.

- В области интересов, касающихся роста, Маша выделила четыре исчерпывающих диапазона, которым соответствуют высказывания: "ниже 180 см", "180 – 190 см", "190 – 200 см", "выше 2 м". Это требует использования еще четырех нейронов рецепторного слоя.

- В части длины носа у Маши выработался свой стереотип, в соответствии с которым она делит носы на "короткие", "картошечкой" и "длинные", также предполагая, что все возможности исчерпаны, и трех рецепторов ей достаточно.

- Наличию шляпы соответствует булевы переменные "шляпа есть" и "шляпы нет". (Не забывать, что они задаются значениями истинности соответствующих высказываний!) Значения этих переменных преобразуются в действительные. Для данных переменных необходимы два рецептора.

Для краткого описания системы принятия решений (СПР) введем обозначения всех фигурирующих высказываний (это отражено на рис.5.1):

Маша создает уже обученную сеть, вводя необходимые связи с единичными весами. Прежде всего она формирует нейрон выходного слоя Вых1, который будет максимально возбуждаться при появлении идеального мужчины. Маша связывает с этим нейроном все рецепторы, реагирующие на интересующие ее значения признаков.

Предположим, что кроме "идеальной" комбинации, Машу интересуют не все возможные комбинации признаков проходящих мужчин. Некоторые комбинации она вовсе не удостаивает вниманием. Однако по некоторым она готова сделать замечания, хотя бы связанные с сожалением о близком счастье. Поэтому создаваемая Машей нейронная сеть содержит несколько нейронов выходного слоя, соответствующих лишь тем решениям, замечаниям и сожалениям, которые готовы слететь с губ за чашкой чая у раскрытого окна.

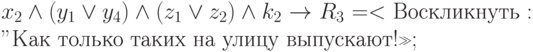

Тогда логическое описание СПР имеет вид:

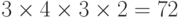

Необходимо отметить, что при решении общей задачи анализа всех возможных ситуаций количество N нейронов выходного слоя в данном случае должно составлять  . Каждый нейрон выходного слоя в этом случае указывал бы на решение, принимаемое для соответствующей ему комбинации значений признаков. В общем случае обработки временного ряда справедливо учитывать все возможные ситуации, принимая по каждой из них отдельное решение.

. Каждый нейрон выходного слоя в этом случае указывал бы на решение, принимаемое для соответствующей ему комбинации значений признаков. В общем случае обработки временного ряда справедливо учитывать все возможные ситуации, принимая по каждой из них отдельное решение.

Учет не всех комбинаций признаков приводит к необходимости тщательного подбора параметров передаточной функции. Ведь решение должно приниматься не просто по максимальному возбуждению нейронов выходного слоя (оно существует всегда!), а по возбуждению, превысившему достаточно высокий порог.

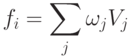

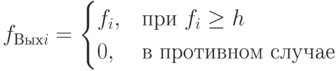

Воспользовавшись рекомендациями Лекции 13, Маша выбирает функцию активации на основе счета значений следующих выражений:

|

( 5.1) |

Здесь  – значение возбуждения на j-м входе нейрона выходного слоя, поступившего от связанного с ним рецептора,

– значение возбуждения на j-м входе нейрона выходного слоя, поступившего от связанного с ним рецептора,  – вес входа (связи). На этапе обучения значение возбуждения рецептора принимается равным единице, если значение высказывания о наличии соответствующего признака является истинным, и равным нулю в противном случае.

– вес входа (связи). На этапе обучения значение возбуждения рецептора принимается равным единице, если значение высказывания о наличии соответствующего признака является истинным, и равным нулю в противном случае.

Порог h выбирается из следующих соображений. Поскольку возбуждение нейрона выходного слоя должно быть высоким только в случае поступления на его вход ровно четырех единиц, следует выбрать значение 4 > h > 3. Легко проверить, что все ситуации, по которым предусмотрено решение, обнаруживаются с помощью высокого возбуждения единственного нейрона выходного слоя. Если ситуация относится к тем, по которым решение не предусмотрено, то ни один нейрон выходного слоя не возбудится, и Маша просто проигнорирует появление на улице очередного мужчины.

На рис.5.1 система принятия решений представлена полностью. Все веса связей равны единице и потому на рисунке не обозначены.

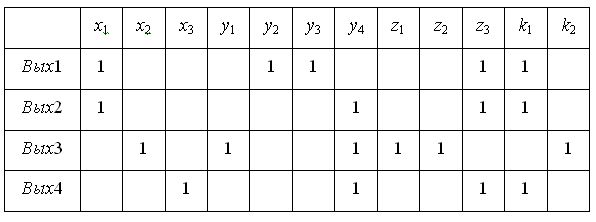

Конечно, в виде, представленном на рисунке, нейронная сеть не обрабатывается компьютером. Информационная технология обработки логической нейронной сети основана на представлении ее матрицей следования (рис.5.2). Каждая строка и столбец соответствуют нейрону, а связи показаны их весами в том столбце, который соответствует их исходу.

Однако, несколько подумав, Маша приходит к выводу, что наличие длинного носа чревато серьезными последствиями в семейной жизни. Нос "картошечкой", несомненно, благотворнее влияет на мягкость нрава. Тогда Маша решает, что при последующей модификации она обязательно положит вес  связи, ведущей из нейрона-рецептора

связи, ведущей из нейрона-рецептора  к нейрону Вых1, равным 0,5. В то же время она введет новую связь, соединяющую нейрон

к нейрону Вых1, равным 0,5. В то же время она введет новую связь, соединяющую нейрон  с нейроном Вых1. Вес этой связи

с нейроном Вых1. Вес этой связи  она выберет также равным 0,5. Приведенный проект не отражен на рисунке. Он лишь иллюстрирует прекрасные возможности взвешенного учета различных факторов при модификации и развитии логической нейронной сети.

она выберет также равным 0,5. Приведенный проект не отражен на рисунке. Он лишь иллюстрирует прекрасные возможности взвешенного учета различных факторов при модификации и развитии логической нейронной сети.

Очевидно, что с помощью построенной однослойной логической нейронной сети можно параллельно (!) исследовать значения всех признаков проходящих мужчин (в общем случае – всего множества признаков каждого объекта временного ряда). Это отражает тот факт, что искусственная нейронная сеть, как и естественная, имитирует параллельную обработку сигналов, одновременно поступивших на все рецепторы, то есть производит распараллеливание выполнения сложных логических конструкций вида "если... то...". Относительно матрицы следования это означает возможность параллельной обработки всех строк, соответствующих нейронам выходного слоя, с помощью передаточной функции. В общем случае эта обработка параллельно-последовательная. Элемент последовательности возникает в связи с преемственностью информации внутри логических цепочек, образуемых нейронами.

Однако при программном исполнении на компьютере непараллельной архитектуры обработка нейроподобных элементов сети производится последовательно. Этого вполне достаточно для Маши, но крайне затруднительно в общем случае обработки временного ряда.

Поэтому построение нейрокомпьютера, допускающего параллельную обработку многих нейронов по SPMD-технологии [6], следует считать обоснованным и актуальным.

Загрузка входного, рецепторного, слоя заключается в формировании массива, каждый элемент которого соответствует рецептору и должен принять значение возбуждения этого рецептора.

Как же автоматизировать возбуждение рецепторов, придавая каждому из них значение 0 или 1 в соответствии с признаком проходящего мужчины?

Предположим, в результате подключения аппаратуры наружного наблюдения к компьютеру, появилась возможность "считывания" значения указанных признаков для каждого проходящего мужчины.

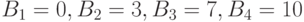

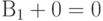

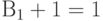

Чтобы поместить эти значения "на место", следует воспользоваться базированием и индексацией. В качестве значения базы  выбирается известный, предусмотренный при программировании, адрес первого элемента подмассива рецепторов, закрепленного за признаком i (i = 1, …, m). Например, для построенной нейронной сети

выбирается известный, предусмотренный при программировании, адрес первого элемента подмассива рецепторов, закрепленного за признаком i (i = 1, …, m). Например, для построенной нейронной сети  .

.

Индекс, или смещение, находится на основе способа градации каждого признака. Например, признак масти мужчины предполагает нумерацию с нуля элементов множества {брюнет, блондин, прочие}. Тогда адрес рецептора, соответствующего высказыванию "брюнет", равен  , адрес рецептора, соответствующего высказыванию "блондин", равен

, адрес рецептора, соответствующего высказыванию "блондин", равен  , и, соответственно, следующий адрес находится как

, и, соответственно, следующий адрес находится как  .

.

Адреса рецепторов, определяющих рост, найти труднее. Для этого необходимо исследовать значения роста и соотносить их с принятым шагом градации  , принимая во внимание минимальное учитываемое значение параметра роста. А именно, в данном случае

, принимая во внимание минимальное учитываемое значение параметра роста. А именно, в данном случае  = 10 (см). Минимальное учитываемое значение признака равно 180 (см). Чтобы его получить, необходимо 0 раз применить (сложить) значение

= 10 (см). Минимальное учитываемое значение признака равно 180 (см). Чтобы его получить, необходимо 0 раз применить (сложить) значение  . Следовательно, 0 – индекс (смещение) для получения, с помощью базы

. Следовательно, 0 – индекс (смещение) для получения, с помощью базы  , адреса рецептора, соответствующего высказыванию "рост меньше 180 см".

, адреса рецептора, соответствующего высказыванию "рост меньше 180 см".

Для получения адреса рецептора, соответствующего высказыванию "рост лежит в пределах от 180 до 190 см", необходимо один раз применить значение  при суммировании с минимальным значением признака. Следовательно, 1 – индекс (смещение) для получения (с помощью

при суммировании с минимальным значением признака. Следовательно, 1 – индекс (смещение) для получения (с помощью  ) адреса рецептора, соответствующего данному высказыванию, и т.д.

) адреса рецептора, соответствующего данному высказыванию, и т.д.

Для остальных признаков индексы при расчете адресов соответствующих рецепторов находятся с помощью баз  и

и  аналогично признаку масти.

аналогично признаку масти.