| Россия, Москва |

Многослойные сети сигмоидального типа

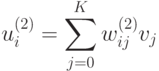

Компоненты градиента рассчитываются дифференцированием зависимости (2). В первую очередь определяются веса нейронов выходного слоя. Для выходных весов получаем:

![\partial E/ \partial w_{ij}^{(2)} = (y_i - d_i)[df(u_i^{(2)})/du_i^{(2)}]v_j,](/sites/default/files/tex_cache/3d32fd5a73de73b537b2abb53ee1ecbb.png)

где

Если ввести обозначение

![\partial_i^{(2)} = (y_i - d_i)[df(u_i^{(2)})/du_i^{(2)}],](/sites/default/files/tex_cache/71234a398099515e25cead0cf8fa2805.png)

то соответствующую компоненту градиента относительно весов выходного слоя можно представить в виде

|

( 3) |

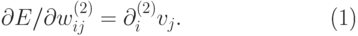

Компоненты градиента относительно нейронов скрытого слоя определяются так же, но описываются более сложной зависимостью, следующей из существования функции, которая задана в виде

![\partial E/ \partial w_{ij}^{(1)} = \sum_{k=1}^M (y_k -

d_k)[dy_k/dv_i][dv_i/dw_{ij}^{(1)}].](/sites/default/files/tex_cache/e5dc3fa5be4e843dce0cc86682d494d8.png)

Отсюда получаем

![\partial E/ \partial w_{ij}^{(1)} =

\sum_{k=1}^M (y_k - d_k)[df(u_k^{(2)}) / du_k^{(2)}] w_{ki}^{(2)}

[df(u_i^{(1)}) / du_i^{(1)}] x_j,](/sites/default/files/tex_cache/6c642977b76d575619a256d9eab77e85.png)

Если ввести обозначение

![\partial_i^{(1)} = \sum_{k=1}^M (y_k -

d_k)[df(u_k^{(2)})/du_k^{(2)}]w_{ki}^{(2)}[df(u_i^{(1)})/du_i^{(1)}],](/sites/default/files/tex_cache/f065d950e8147dc8bc817aeb72f06071.png)

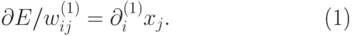

то получим выражение, определяющее компоненты градиента относительно весов нейронов входного слоя в виде

|

( 4) |

В обоих случаях (формулы (3) и (4)) описания градиента имеют аналогичную

структуру и

представляются произведением двух сигналов: первый соответствует начальному

узлу данной

взвешенной связи, а второй — величине погрешности, перенесенной на узел,

с которым эта связь

установлена. Определение вектора градиента важно для последующего процесса

уточнения весов.

В классическом алгоритме обратного распространения ошибки вектор  в выражении (1)

задает направление антиградиента (метод наискорейшего спуска), поэтому

в выражении (1)

задает направление антиградиента (метод наискорейшего спуска), поэтому

В соответствии с алгоритмом обратного распространения ошибки в каждом цикле обучения выделяются следующие этапы:

1. Анализ нейронной сети в прямом направлении передачи информации при

генерации входных сигналов, составляющих очередной вектор  В

результате такого анализа рассчитываются значения выходных сигналов

нейронов скрытых слоев и выходного слоя, а также соответствующие

производные

В

результате такого анализа рассчитываются значения выходных сигналов

нейронов скрытых слоев и выходного слоя, а также соответствующие

производные  функций активации каждого слоя

(

функций активации каждого слоя

(  - количество слоев сети).

- количество слоев сети).

2. Создание сети обратного распространения ошибок путем изменения направлений передачи сигналов на обратные, замена функций активации их производными и подача на бывший выход (а в настоящий момент - вход) сети сигнала в виде разности между фактическим и ожидаемым значением. Для определенной таким образом сети необходимо рассчитать значения требуемых обратных разностей.

3. Уточнение весов (обучение сети) производится по предложенным выше формулам для оригинальной сети и для сети обратного распространения ошибки.

4. Описанный процесс следует повторить для всех обучающих примеров задачника, продолжая его вплоть до выполнения условия остановки алгоритма. Действие алгоритма завершается в момент, когда норма градиента упадет ниже априори заданного значения, характеризующего точность процесса обучения.

Руководствуясь рис. 2, можно легко определить все компоненты градиента

целевой функции, т.е. все

частные производные функции  по весам сети. Для этого, двигаясь

от входов сети (бывших выходов),

нужно перемножить все встречающиеся на пути величины (кроме весов

по весам сети. Для этого, двигаясь

от входов сети (бывших выходов),

нужно перемножить все встречающиеся на пути величины (кроме весов  , для которых

рассчитывается частная производная

, для которых

рассчитывается частная производная  ).

Кроме того, там, где дуги

сходятся к одной вершине, нужно выполнить сложение произведений, полученных на

этих дугах.

).

Кроме того, там, где дуги

сходятся к одной вершине, нужно выполнить сложение произведений, полученных на

этих дугах.

Так, например, чтобы посчитать производную  ,

нужно перемножить величины

,

нужно перемножить величины  , а

для вычисления производной

, а

для вычисления производной  нужно

посчитать

произведения

нужно

посчитать

произведения

![\pi_1=(y_1 - d_1)\times[\partial f(u_1^{(2)})

/\partial

u_1^{(2)}] w_{12}^{(2)}](/sites/default/files/tex_cache/3e5337add596ba0cd78afe66ae7e612a.png)

и

![\pi_2=(y_2 - d_2) [\partial

f(u_2^{(2)}) /

\partial u_2^{(2)}] w_{22}^{(2)}](/sites/default/files/tex_cache/c81580bfedf31005cf81e2a6062bd600.png)

и затем сложить эти произведения и

результат умножить на  и

и

Таким образом, получим

![\partial E / \partial w_{12}^{(1)}=(\pi_1+\pi_2)[\partial f(u_2^{(1)}) /

\partial u_2^{(1)}] x_1

=\\](/sites/default/files/tex_cache/45d86f0056c38b7f68901c17afbdafef.png)

![=[(y_1-d_1)[\partial f(u_1^{(2)})/\partial u_1^{(2)}]w_{12}^{(2)} + (y_2

-d_2)

[\partial f(u_2^{(2)})/\partial u_2^{(2)})]w_{22}^{(2)}]\times\\](/sites/default/files/tex_cache/045bf1311acb9f46714e2a7ebdef42d5.png)

![\times [ \partial f(u_2^{(1)})/\partial u_2^{(1)}] x_1 = x_1

\sum^2_{k=1} (y_k-d_k)[\partial f(u_k^{(2)})/

\partial u_k^{(2)}]w_{k2}^{(2)} [\partial f(u_2^{(1)})/ \partial

u_2^{(1)}].](/sites/default/files/tex_cache/2c4b0ce39b12b510ed30262ef2976d6d.png)