|

Здравствуйте,ясдавала 15 тестов и экзамен. Мне нужно сейчас посмотреть результаты тестов.Как это сдлеать? |

Информация, ее представление и измерение

Любые сообщения измеряются в байтах, килобайтах, мегабайтах, гигабайтах, терабайтах, петабайтах и эксабайтах, а кодируются, например, в компьютере, с помощью алфавита из нуля и единицы, записываются и реализуются в ЭВМ в битах.

Приведем основные соотношения между единицами измерения сообщений:

1 бит ( bi nary digi t – двоичное число) = 0 или 1,

1 терабайт (1Тб) = 243 бит,

Пример. Найти неизвестные х и у, если верны соотношения:

128y (К) = 32x ( бит );

2x (М) = 2y ( байт ).

Выравниваем единицы измерения информации:

27y (K) = 27y+13 ( бит );

2x (M) = 2x+20 ( байт ).

Подставляя в уравнения и отбрасывая размерности информации, получаем:

27y+13 = 25x

2x+20=2y

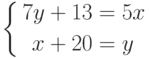

Отсюда получаем систему двух алгебраических уравнений:

или, решая эту систему, окончательно получаем, x = –76,5, у = –56,5.

Для измерения информации используются различные подходы и методы, например, с использованием меры информации по Р. Хартли и К. Шеннону.

Количество информации – число, адекватно характеризующее разнообразие (структурированность, определенность, выбор состояний и т.д.) в оцениваемой системе. Количество информации часто оценивается в битах, причем такая оценка может выражаться и в долях бит (так как речь идет не об измерении или кодировании сообщений ).

Мера информации – критерий оценки количества информации. Обычно она задана некоторой неотрицательной функцией, определенной на множестве событий и являющейся аддитивной, то есть мера конечного объединения событий (множеств) равна сумме мер каждого события.

Рассмотрим различные меры информации.

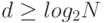

Возьмем меру Р. Хартли. Пусть известны N состояний системы S ( N опытов с различными, равновозможными, последовательными состояниями системы). Если каждое состояние системы закодировать двоичными кодами, то длину кода d необходимо выбрать так, чтобы число всех различных комбинаций было бы не меньше, чем N:

Логарифмируя это неравенство, можно записать:

Наименьшее решение этого неравенства или мера разнообразия множества состояний системы задается формулой Р. Хартли:

H = log2N ( бит ).

Пример. Чтобы определить состояние системы из четырех возможных состояний, то есть получить некоторую информацию о системе, необходимо задать 2 вопроса. Первый вопрос, например: "Номер состояния больше 2?". Узнав ответ ("да", "нет"), мы увеличиваем суммарную информацию о системе на 1 бит ( I = log22 ). Далее необходим еще один уточняющий вопрос, например, при ответе "да": "Состояние – номер 3?". Итак, количество информации равно 2 битам ( I = log24 ). Если система имеет n различных состояний, то максимальное количество информации равно I = log2n .

Если во множестве X = {x1, x2, ..., xn} искать произвольный элемент, то для его нахождения (по Хартли) необходимо иметь не менее logan (единиц) информации.

Уменьшение Н говорит об уменьшении разнообразия состояний N системы.

Увеличение Н говорит об увеличении разнообразия состояний N системы.

Мера Хартли подходит лишь для идеальных, абстрактных систем, так как в реальных системах состояния системы неодинаково осуществимы (неравновероятны).

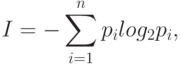

Для таких систем используют более подходящую меру К. Шеннона. Мера Шеннона оценивает информацию отвлеченно от ее смысла:

где n – число состояний системы; рi – вероятность (относительная частота) перехода системы в i-е состояние, а сумма всех pi должна равняться 1.

Если все состояния рассматриваемой системы равновозможны, равновероятны, то есть рi = 1/n , то из формулы Шеннона можно получить (как частный случай) формулу Хартли:

I = log2n .

Пример. Если положение точки в системе из 10 клеток известно, например если точка находится во второй клетке, то есть

рi = 0, i = 1, 3, 4, …, 10, р2 = 1 ,

то тогда получаем количество информации, равное нулю:

I = log21 = 0 .

Обозначим величину:

fi = –nlog2pi.

Тогда из формулы К. Шеннона следует, что количество информации I можно понимать как среднеарифметическое величин fi , то есть величину fi можно интерпретировать как информационное содержание символа алфавита с индексом i и величиной pi вероятности появления этого символа в любом сообщении ( слове ), передающем информацию.