Теория адаптивного резонанса. Реализация

Инициализация весов bij

Инициализация весов  малыми значениями является

существенной для корректного функционирования систем APT. Если они

слишком большие, входной вес вектора, который уже был запомнен, станет

скорее активизировать несвязанный нейрон, чем ранее обученный.

малыми значениями является

существенной для корректного функционирования систем APT. Если они

слишком большие, входной вес вектора, который уже был запомнен, станет

скорее активизировать несвязанный нейрон, чем ранее обученный.

Установка этих весов в малые величины гарантирует, что несвязанные

нейроны не будут получать возбуждения большего, чем обученные нейроны

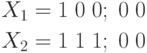

в слое распознавания. Используя предыдущий пример с  ,

,  и

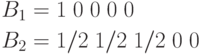

и  , произвольно установим

, произвольно установим  С

такими весами

предъявление вектора, которому сеть была ранее обучена, приведет к более

высокому уровню активации для правильно обученного нейрона в слое

распознавания, чем для несвязанного нейрона. Например, для несвязанного

нейрона

С

такими весами

предъявление вектора, которому сеть была ранее обучена, приведет к более

высокому уровню активации для правильно обученного нейрона в слое

распознавания, чем для несвязанного нейрона. Например, для несвязанного

нейрона  будет

производить возбуждение 1/6, в то время как

будет

производить возбуждение 1/6, в то время как  будет производить возбуждение 1/2; и то, и

другое ниже возбуждения

для обученных нейронов.

будет производить возбуждение 1/2; и то, и

другое ниже возбуждения

для обученных нейронов.

Поиск. Может показаться, что в описанных алгоритмах отсутствует необходимость фазы поиска, за исключением случая, когда для входного вектора должен быть распределен новый несвязанный нейрон. Это не совсем так: предъявление входного вектора, сходного, но не абсолютно идентичного одному из запомненных образов, может при первом испытании не обеспечить выбор нейрона слоя распознавания с уровнем сходства, большим р, хотя такой нейрон будет существовать; и, тем самым, без поиска не обойтись.

Как и в предыдущем примере, предположим, что сеть обучается следующим двум векторам:

с векторами весов  ,

обученными следующим образом:

,

обученными следующим образом:

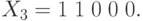

Теперь приложим входной вектор  В этом

случае возбуждение нейрона 1 в слое распознавания будет 1,0, а нейрона 2

только 2/3. Нейрон 1 выйдет победителем (хотя он не лучшим образом

соответствует входному вектору), вектор

В этом

случае возбуждение нейрона 1 в слое распознавания будет 1,0, а нейрона 2

только 2/3. Нейрон 1 выйдет победителем (хотя он не лучшим образом

соответствует входному вектору), вектор  получит значение 1 1 0

0 0,

получит значение 1 1 0

0 0,  будет равно 1/2. Если уровень сходства установлен в 3/4, нейрон 1 будет

заторможен и нейрон 2 выиграет состязание.

будет равно 1/2. Если уровень сходства установлен в 3/4, нейрон 1 будет

заторможен и нейрон 2 выиграет состязание.  станет равным 1 1 0

0 0,

станет равным 1 1 0

0 0,  станет равным 1, критерий сходства будет удовлетворен, и поиск

закончится.

станет равным 1, критерий сходства будет удовлетворен, и поиск

закончится.

Теоремы APT

Гроссберг доказал некоторые теоремы, которые описывают характеристики сетей APT. Четыре результата, приведенные ниже, являются одними из наиболее важных:

- После стабилизации процесса обучения предъявление одного из обучающих векторов (или вектора с существенными характеристиками категории) будет активизировать требуемый нейрон слоя распознавания без поиска. Такая характеристика "прямого доступа" обеспечивает быстрый доступ к предварительно изученным образам.

- Процесс поиска является устойчивым. После определения

выигравшего нейрона в сети не будет возбуждений других нейронов из-за

изменения векторов выхода слоя сравнения

; только сигнал сброса

может вызвать такие изменения.

; только сигнал сброса

может вызвать такие изменения. - Процесс обучения является устойчивым. Обучение не будет вызывать переключения с одного возбужденного нейрона слоя распознавания на другой.

- Процесс обучения конечен. Любая последовательность произвольных входных векторов будет производить стабильный набор весов после конечного количества обучающих серий. Повторяющиеся последовательности обучающих векторов не будут приводить к циклическому изменению весов.