|

как начать заново проходить курс, если уже пройдено несколько лекций со сданными тестами? |

Необходимые сведения о случайных величинах

5.2.2 Пропускная способность канала и количество принятой информации

Определение 5.14 Пропускная способность канала связи - наибольшая теоретически достижимая скорость передачи информации при условии, что погрешность не превосходит заданной величины.

Определение 5.15 Скорость передачи информации - среднее количество информации, передаваемое в единицу времени. Определим выражения для расчета скорости передачи информации и пропускной способности дискретного канала связи.

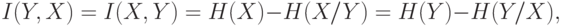

При передаче каждого символа в среднем по каналу связи проходит количество информации, определяемое по формуле:

|

( 5.3) |

где  - взаимная информация, т.е. количество информации, содержащееся в

- взаимная информация, т.е. количество информации, содержащееся в  относительно

относительно  ;

;  - энтропия источника сообщений;

- энтропия источника сообщений;  - условная энтропия, определяющая потерю информации на один символ, связанную с наличием помех и искажений.

- условная энтропия, определяющая потерю информации на один символ, связанную с наличием помех и искажений.

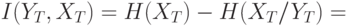

При передаче сообщения  длительности

длительности  , состоящего из

, состоящего из  элементарных символов, среднее количество передаваемой информации с учетом симметрии взаимного количества информации равно:

элементарных символов, среднее количество передаваемой информации с учетом симметрии взаимного количества информации равно:

|

( 5.4) |

![H(Y_T)-H(Y_T/X_T) = n[H(X)-H(X/Y)],](/sites/default/files/tex_cache/04975fe6fd40329c368c84020b818b37.png) |

( 5.5) |

где  ;

;  - среднее время передачи одного символа;

- среднее время передачи одного символа;  -число символов в сообщении длительностью

-число символов в сообщении длительностью  .

.

Для символов равной длительности  , в случае неравновероятных символов неравной длительности

, в случае неравновероятных символов неравной длительности  .

.

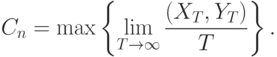

При этом скорость передачи информации

![C=\bar{I}(X_T,Y_T)=\lim_{T\rightarrow \infty} \frac{(X_T,Y_T)}{T} \text{ [бит/с]}.](/sites/default/files/tex_cache/cf3c5e54a774f391e1c47def09a32617.png) |

( 5.6) |

Скорость передачи информации зависит от статистических свойств источника, метода кодирования и свойств канала.

Пропускная способность дискретного канала связи

|

( 5.7) |

Пример 5.4 [2] Источник вырабатывает 3 сообщения с вероятностями:  ,

,  и

и  . Сообщения независимы и передаются равномерным двоичным кодом (

. Сообщения независимы и передаются равномерным двоичным кодом ( ) с длительностью символов, равной

) с длительностью символов, равной  мс. Определить скорость передачи информации по каналу связи без помех.

мс. Определить скорость передачи информации по каналу связи без помех.

Решение. Энтропия источника равна

![H=-\sum_{i=1}^{m} p_i \log_2 p_i = - \left( 0,1 \log_2 0,1 + 0,2 \log_2 0,2+ 0,7 \log_2 0,7\right)=1,16 \text{ [бит/с].}](/sites/default/files/tex_cache/2a0002e1b850da8a288fdf2663e4377b.png)

Для передачи 3 сообщений равномерным кодом необходимо два разряда, при этом длительность кодовой комбинации равна  .

.

Средняя скорость передачи сигнала

![V =1/2\tau = 500 \text{ [1/c]}.](/sites/default/files/tex_cache/45efa89b1f23b0d9ab15c04a22c641ba.png)

Скорость передачи информации

![C = vH = 500\cdot1,16 = 580 \text{ [бит/с]}.](/sites/default/files/tex_cache/b90a9eb20bbfeb5e50b2a2bd57815436.png)

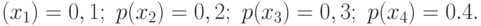

Пример 5.5 По каналу связи передаются сообщения, вероятности которых соответственно равны:

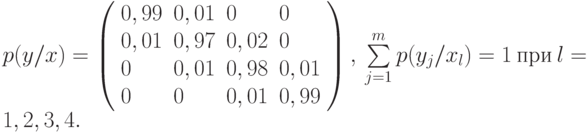

Канальная матрица, определяющая потери информации в канале связи имеет вид:

Определить:

- Энтропию источника информации -

.

. - Безусловную энтропию приемника информации -

.

. - Общую условную энтропию -

.

. - Скорость передачи информации, если время передачи одного символа первичного алфавита

мс.

мс. - Определить потери информации в канале связи при передаче

символов алфавита.

символов алфавита. - Среднее количество принятой информации.

- Пропускную способность канала связи.

Решение:

- Энтропия источника сообщений равна

![\begin{equation}

H(X)=-\sum\limits_{i=1}^{m} p(x_i) \log_2 p(x_i) = \\

- ( 0,1 \log_2 0,1+0,2 \log_2 0,2+0,3 \log_2 0,3+0,4 \log_2 0,4)= \\

0,3322+0,4644+0,5211+0,5288=1,8465 \text{ [бит/симв.]}

\end{equation}](/sites/default/files/tex_cache/a60a2049b105aa2c437671171a4e7e03.png)

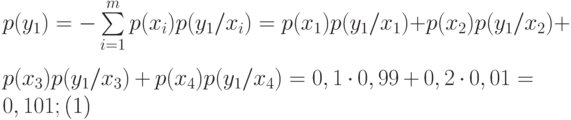

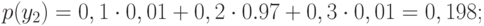

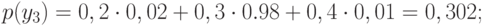

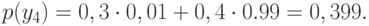

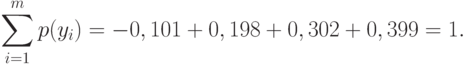

- Вероятности появления символов на входе приемника

Проверка:

Проверка: Энтропия приемника информации равна

Энтропия приемника информации равна

![\begin{equation}

H(Y)=-\sum\limits_{i=1}^m p(y_i) \log_2 p(y_i)=\\

-(0,101 \log_2 0,101 + 0,198 \log_2 0,198 + 0,302 \log_2 0,302 + 0,399 \log_2 0,399 =\\

0,334+0,4626+0,5216+0,5290=1,85 \text{ [бит/симв].}

\end{equation}](/sites/default/files/tex_cache/b544af09eac6d119c1930ae31d4b6bd4.png)

- Общая условная энтропия равна

![H(Y/X)=-\sum_{i=1}^m \sum_{j=1}^m p(x_i) p(y_j/x_i) \log_2 p(y_j/x_i)=\\

-\left(

0,1(0,99 \log_2 0,99 + 0,01 \log_2 0,01)+\right.\\

0,2(0,01 \log_2 0,01 + 0,97 \log_2 0,97+ 0,02 \log_2 0,02)+\\

0,3(0,01 \log_2 0,01 + 0,98 \log_2 0,98+ 0,01 \log_2 0,01)+\\

\left. 0,4(0,01 \log_2 0,01 + 0,99 \log_2 0,99)

\right)= \\

0,008+0,044+0,048+0,032=0,133 \text{ [бит/симв].}](/sites/default/files/tex_cache/74843564106f76f8f95ac25a4fc705f9.png)

- Скорость передачи информации равна:

![C=V\left(H(Y)-H(Y/X)\right)=V\left(H(X)-H(X/Y)\right)=\\

(1,85-0,132)/0,0001=17,18 \text{ [Кбит/с].}](/sites/default/files/tex_cache/98641d4a43f3ccd0f86d43f819c88915.png)

- Потери информации в канале связи при передаче 500 символов алфавита равны:

![\Delta I=kH(Y/X) = 500\cdot 0,132=66 \text{ [бит.]}](/sites/default/files/tex_cache/0c2e5146bd4e76f604cbf210969eab36.png)

- Среднее количество принятой информации равно:

![I=k\left(H(Y)-H(Y/X)\right)=k\left(H(X)-H(X/Y)\right)=\\

500\cdot(1,85-0,132)=859 \text{ [бит].}](/sites/default/files/tex_cache/86eb34cc9b542188889a88d7a4979274.png)

- Пропускная способность канала связи

![C_n=V\left( \log_2 m - H(Y/X) \right)=(2-0,132)/0,0001=18,68 \text{ [Кбит/с].}](/sites/default/files/tex_cache/3a4f73a36fc44d940041310882541e24.png)

Список литературы

- Харин Ю.С., Берник В.И., Матвеев Г.В. Математические основы криптологии - Минск: БГУ, 1999. - 319 с.

- Блинцов С.В. Сборник примеров и задач по теории информации. Николаев: НУК им. адмирала Макарова, 2004..

- Рябко Б.А., Филонов А.Н. Криптографические методы защиты информации: Учебное пособие для ВУЗов. Новосиб.: СибГУТИ, 2008. - 229 с.